Um Ihnen die Funktionen unseres Online-Shops uneingeschränkt anbieten zu können setzen wir Cookies ein. Weitere Informationen

NVIDIA HGX

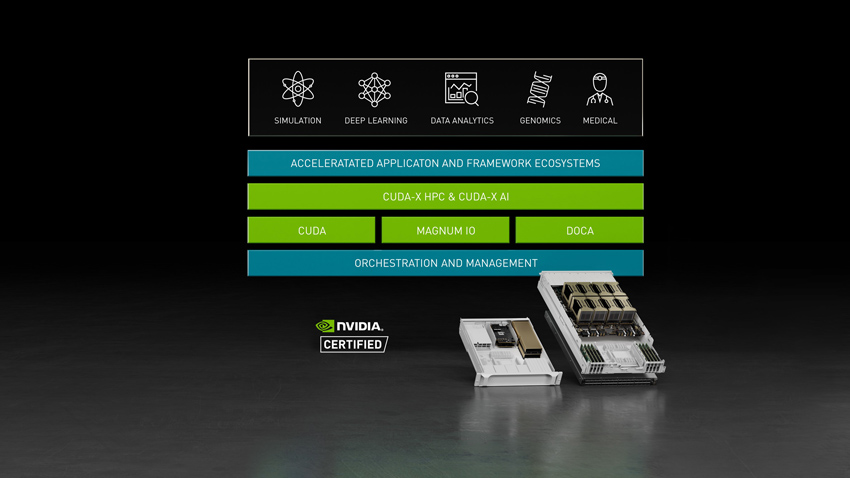

Speziell für die Konvergenz von Simulationen, Datenanalysen und KI entwickelt

. Massive Datensätze, riesige Modelle beim Deep Learning und komplexe Simulationen erfordern mehrere Grafikprozessoren mit extrem schnellen Verbindungen und einem vollständig beschleunigten Softwarestack. Die NVIDIA HGX™-KI–Supercomputing-Plattform vereint die volle Leistung von NVIDIA-Grafikprozessoren, NVIDIA® NVLink®, NVIDIA InfiniBand-Netzwerken und einem vollständig optimierten NVIDIA KI- und HPC-Softwarestack aus dem NVIDIA NGC™-Katalog für höchste Anwendungsleistung. Dank der durchgängigen Leistung und Flexibilität ermöglicht es NVIDIA HGX Forschern und Wissenschaftlern, Simulationen, Datenanalysen und KI zu kombinieren, um wissenschaftlichen Fortschritt voranzutreiben.

Technische Daten zu NVIDIA HGX

NVIDIA HGX ist als einzelne Hauptplatine mit vier oder acht H100-GPUs und 80 GB GPU-Speicher oder mit A100-GPUs mit jeweils 40 GB oder 80 GB GPU-Speicher erhältlich. Die Konfiguration mit 4 Grafikprozessoren ist vollständig mit NVIDIA NVLink verbunden und die Konfiguration mit 8 Grafikprozessoren ist über NVIDIA NVSwitch miteinander verbunden. Bis zu 32 HGX H100-Systeme mit 8 GPUs können mithilfe des NVIDIA NVLink Switch-Systems für Cluster mit einem Umfang von bis zu 256 GPUs kombiniert werden. Zwei HGX A100-Hauptplatinen können mit einer NVSwitch-Verbindung kombiniert werden, um einen leistungsstarken Einzelknoten mit 16 Grafikprozessoren zu erstellen.

HGX ist auch in einem PCIe-Formfaktor als einfach bereitzustellende Option verfügbar, die höchste Rechenleistung auf Mainstream-Servern bietet.

Diese leistungsstarke Kombination aus Hard- und Software legt den Grundstein für die ultimative KI-Supercomputing-Plattform.

| HGX H100 (Hopper) | ||||

| H100 PCIe | 4-GPU | 8-GPU | 256-GPU | |

| GPUs | 1x NVIDIA H100 PCIe | HGX H100 4-GPU | HGX H100 8-GPU | 32 8x NVIDIA H100 SXM-Knoten, die über das NVLink-Switch-System verbunden sind |

| Formfaktor | PCIe | 4x NVIDIA H100 SXM | 8x NVIDIA H100 SXM | 16x NVIDIA H100 SXM |

| HPC- und KI-Berechnungen (FP64/TF32/FP16/FP8/INT8) | 48TF/800TF/1.6PF/3.2PF/3.2 POPS | 240TF/4PF/8PF/16PF/16POPS | 480TF/8PF/16PF/32PF/32POPS | 15PF/256PF/512PF/1EF/1EOPS |

| Arbeitsspeicher | 80 GB pro Grafikprozessor | Bis zu 320 GB | Bis zu 640 GB | Bis zu 20 TB |

| NVLink | Vierte Generation | Vierte Generation | Vierte Generation | Vierte Generation |

| NVSwitch | N/A | N/A | Dritte Generation | Dritte Generation |

| NVLink-Switch | N/A | N/A | N/A | Erste Generation |

| NVSwitch-Bandbreite für Verbindungen zwischen GPUs | N/A | N/A | 900 GB/s | 900 GB/s |

| Gesamte aggregierte Bandbreite | 900 GB/s | 3,6 TB/s | 7,2 TB/s | 57,6 TB/s |

| HGX A100 (Ampere) | ||||

| A100 PCIe | 4-GPU | 8-GPU | 16-GPU | |

| GPUs | 1x NVIDIA A100 PCIe | HGX A100 4-GPU | HGX A100 8-GPU | 2x HGX A100 8-GPU |

| Formfaktor | PCIe | 4x NVIDIA A100 SXM | 8x NVIDIA A100 SXM | 16x NVIDIA A100 SXM |

| HPC- und KI-Berechnungen (FP64/TF32/FP16/FP8/INT8) | 19.5TF/312TF/624TF/1.2POPS | 78TF/1.25PF/2.5PF/5POPS | 156TF/2.5PF/5PF/10POPS | 312TF/5PF/10PF/20POPS |

| Arbeitsspeicher | 80 GB pro Grafikprozessor | Bis zu 320 GB | Bis zu 640 GB | Bis zu 1.280 GB |

| NVLink | Dritte Generation | Dritte Generation | Dritte Generation | Dritte Generation |

| NVSwitch | N/A | N/A | Zweite Generation | Zweite Generation |

| NVSwitch-Bandbreite für Verbindungen zwischen GPUs | N/A | N/A | 600 GB/s | 600 GB/s |

| Gesamte aggregierte Bandbreite | 600 GB/s | 2,4 TB/s | 4,8 TB/s | 9,6 TB/s |

Eine große Auswahl an DELTA HGX-Systemen

Mit Hilfe unserem Web-Konfigurator, haben Sie die Möglichkeit Ihren passenden GPU-Server zusammen zu stellen. Zur Auswahl stehen unterschiedlichen CPU Serien (AMD oder Intel), Speicherbestückungen sowie die Anzahl der GPUs (4 bis 8 Stück) inklusive der vierten NVLink Generation.

Beschleunigung von HGX mit NVIDIA Networking

Mit HGX ist es auch möglich, NVIDIA-Netzwerke einzubeziehen, um Datenübertragungen zu beschleunigen und zu entlasten und die volle Nutzung der Rechenressourcen sicherzustellen. Smart Adapters und Switches reduzieren die Latenz, steigern die Effizienz, erhöhen die Sicherheit und vereinfachen die Automatisierung von Rechenzentren, sodass die Leistung von End-to-End-Anwendungen beschleunigt wird.

Das Rechenzentrum ist die Recheneinheit der Zukunft und HPC-Netzwerke spielen eine wesentliche Rolle bei der Skalierung der Anwendungsleistung im gesamten Rechenzentrum. NVIDIA InfiniBand ebnet den Weg mit softwaredefinierten Netzwerken, Beschleunigungsmodulen mit netzwerkinternem Computing, Remote-Direktspeicherzugriff (RDMA) und den höchsten Geschwindigkeiten und schnellsten Datenfeeds.

Haben Sie Fragen zu den NVIDIA HGX Produkten, helfen oder geben wir Ihnen dazu gerne eine Auskunft.

Kontakt: Tel: +49 40 300672 - 0 | Fax: +49 40 300672 - 11 | E-Mail: info[at]delta.de

NVIDIA DGX Anfrage

NVIDIA DGX Anfrage